Dienstleistungen für

Qualitätssicherung

Ihr Augenmerk liegt auf qualitativ hochwertigen Trainingsdaten für Ihr KI-Vorhaben oder Sie sind sich nicht ganz sicher, wie gut Ihre Daten eigentlich annotiert sind?

Kontaktieren Sie uns noch heute, um mit uns über Datenqualität zu sprechen!

Kompromisslose Qualitätskontrolle für verlässliche Trainingsdaten

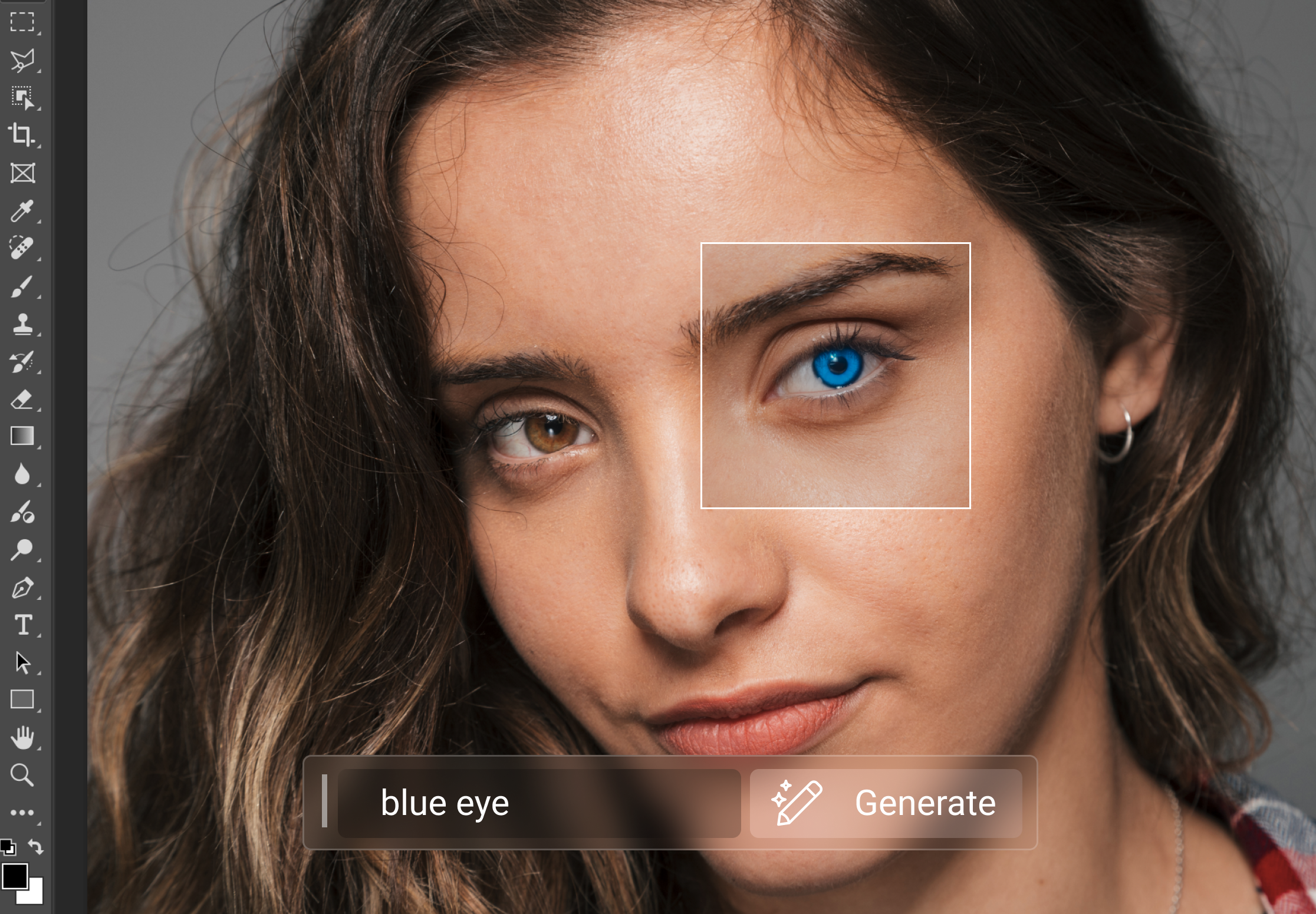

Rigorose Qualitätskontrolle bei der Annotation von Trainingsdaten für KI-Projekte gewährleistet die Zuverlässigkeit, Genauigkeit und ethische Konformität von KI-Systemen, verbessert die Leistung und verringern das Risiko von Fehlern oder Verzerrungen.

Validierung von Trainingsdaten

Bei der Validierung bereits annotierter Daten (inhouse oder durch andere Anbieter) prüfen wir die Richtigkeit der Anmerkungen gemäß den bereitgestellten Richtlinien und stellen so die Einhaltung vorgegebener Standards sicher. Fehlerhafte Annotationen werden identifiziert und berichtigt, fehlende Annotationen hinzugefügt. Zusammen mit unserer Dokumentation können Sie transparent nachvollziehen, wie sich die Gesamtqualität und die Konsistenz des Datensatzes durch unsere Validierung verbessert hat.

Qualitätssicherung

In jahrelanger Kleinarbeit haben wir deshalb einen Prozess für Qualitätskontrolle entwickelt, mit dem mindestens 95%, auf Wunsch auch 98% oder 99% Ihrer Trainingsdaten absolut korrekt annotiert sind. Wir stellen die Richtigkeit der Annotationen auf Grundlage Ihrer Richtlinien sicher und erstellen detaillierte Statistiken zur Ausgabequalität. Unsere Abteilung für Qualitätssicherung gibt unseren Annotatoren regelmäßiges Feedback zu Fehlern und erstellt Berichte über systematische Ungenauigkeiten. Im Anschluss werden fehlerhafte Annotationen berichtigt, um das gewünschte Niveau an Genauigkeit sicherzustellen.

Arbeiten Sie mit führenden Spezialisten an Ihrem KI/ ML-Projekt

KONTAKT AUFNEHMENIhre Vorteile

Globale Reichweite

Unsere globale Reichweite ermöglicht es unseren Kunden, auf mehrsprachige Teams für Data Annotation, LLM Training, KI Beratung und Kundensupport zurückzugreifen. Unser Fachwissen und sprachliche Kompetenzen helfen ihnen, Daten effizient zu verarbeiten, weltweit zu kommunizieren und kulturelle und zeitliche Barrieren zu überwinden.