Prompting und Prompt Engineering für LLMs

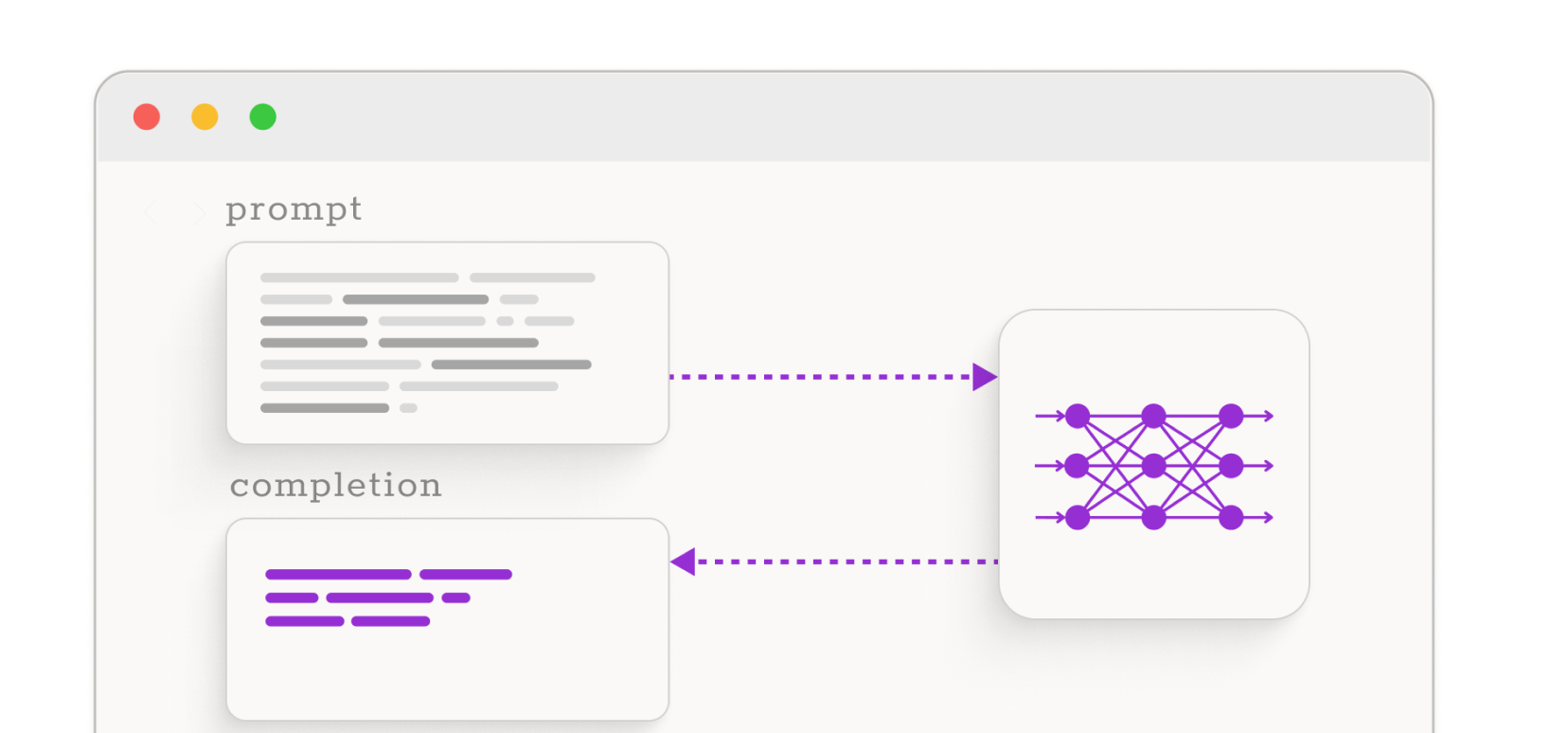

Prompt Engineering (Eingabeaufforderung) ist eine aus dem Wachstum großer Sprachmodelle neu entstandene KI-Disziplin. Beim LLM Prompt Engineering geht es um das Entwerfen und Optimieren von Eingabeaufforderungen für eine effektive Interaktion mit großen Sprachmodellen. Da die Qualität der Modellausgabe von der Qualität der Prompts beeinflusst wird, bewerten Prompt-Ingenieure die Ausgabequalität des Modells und identifizieren Verbesserungsmöglichkeiten in Prompts: eine wichtige Aufgabe, um sicherzustellen, dass die Qualität und Art der von den Sprachsystemen generierten Antworten genau auf die Kommentare und Fragen der Benutzer eingehen.

Prompt Engineering zur Verbesserung der Input-Qualität

Mindy Support Prompt-Ingenieure sind nicht nur mit den Grundlagen des Promptings vertraut, sondern mit den neuesten Techniken, Methoden und Strategien ausgestattet, um Eingabeaufforderungen auf bessere Leistung und Ergebnisse zu optimieren. Dazu gehören:

Kontextualisierte Prompts

Die Integration relevanter kontextbezogener Informationen, Daten oder Fakten in Prompts unterfüttert das LLM mit klaren Details und Informationen über die Situation oder Aufgabe, die es ausführen soll, vergleichbar mit einer Hintergrundgeschichte oder einer Szenenbeschreibung. Dies hilft dem KI-System zu verstehen, was es tun soll und für wen es es tun soll.

Iteratives Prompt Engineering

Beim iterativen Prompting werden Eingabeaufforderungen an eine generative KI systematisch verfeinert und angepasst, um die Relevanz, Genauigkeit und Tiefe der Ergebnisse zu verbessern. Es handelt sich um einen dynamischen Prozess, der sich auf der Grundlage von Feedback weiterentwickelt und von den Prompt-Ingenieuren Anpassungsfähigkeit und Aufmerksamkeit für die Antworten der generativen KI erfordert.

Iteratives Refinement

Bei der iterativen Verfeinerung wird die Eingabeaufforderung auf Grundlage vorheriger Ausgaben schrittweise angepasst, um die Ergebnisse zu optimieren. Dieser „Trial and Error“ Ansatz hilft dabei, die Eingabeaufforderungen für eine optimale Leistung zu verfeinern. Anschließend nutzen wir das Feedback der Nutzer oder zusätzliche Tests.

Kontrollen und Einschränkungen

Für eine präzisere Content Automatisierung definieren Prompt-Ingenieure Einschränkungen, beispielsweise an die Länge oder das Format der Ausgabe oder an den Ton oder Stil. Durch die Anpassung der Ausgabe an Einschränkungen können systematisch verzerrte Ausgaben und das Verhalten der generativen KI teils gesteuert werden.

Erstellung korrekter Prompt Templates

Unsere Prompt-Ingenieure nutzen Prompt-Design Best Practices, um klare, präzise und detaillierte Eingabeaufforderungen zu erstellen. Dabei werden in der Regel Fachjargon und technische Begriffe vermieden und natürliche Sprache und Richtlinien zur Textgenerierung verwendet. Häufig werden der generativen KI verschiedene Beispiele zur Verfügung gestellt, damit sie aus den verschiedenen Fällen lernen kann (Multi-Shot-Prompting).

Prompt Formatting

Das beim Fine-Tuning verwendete Prompt Format, ist das, mit dem ein LLM am besten zurechtkommt. Sehr große LLMs können auch etwas unbekannte Formate aufnehmen. Dennoch reagieren LLMs empfindlich auf Änderungen des Prompt Formats. Unsere Prompt-Ingenieure können Eingabeaufforderungen so organisieren, dass sie für Ihr Modell verständlich sind (z.B. für Zero-Shot-Prompting, das Anweisungen und einen gewissen Kontext erfordert) oder in einem Format Ihrer Wahl, beispielsweise Q&A oder „füll die Lücke“. Verschiedene Formate können helfen vorherzusagen, wie ein Modell reagiert, wenn es keine Beispiele für Anweisungen erhält, oder welche Formatierung die geringste Wahrscheinlichkeit für versehentliche Verwechslungen bietet, wenn das Modell verwirrt ist.

Warum Mindy Support?

Präzise, korrekt formatierte Eingabeaufforderungen können im Rahmen eines iterativen Refinements die Qualität kommerzieller LLM Anwendungen erheblich verbessern. Es gibt ein paar gute Gründe für eine Zusammenarbeit mit Mindy Support beim Prompt Engineering:

Globale Präsenz

Prompt Engineering erfordert Fachkräfte, die sich mit dieser neuen KI-Disziplin auskennen. Unter Rückgriff auf weltweit verteilte Standorte können wir multilinguale LLM Prompt Engineering Teams zusammenstellen, die sicherstellen, dass die Qualität und Art der von Ihren Sprachsystemen generierten Antworten genau auf die Kommentare und Fragen der Benutzer eingehen.